[Из песочницы] Как мы А/Б тесты проводим

В последнее время на Хабре появляется все больше постов о целесообразности проведения А/Б тестирований (об их пользе, увеличении конверсий). Если внимательно следовать инструкциям — получается очень интересная вещь: незначительное изменение интерфейса и логики вывода информации может привести к значительному изменению конверсии, если перемножить все цифры конверсий под подобным катом — то можем получить рост и в 2 раза.Уже представляю себе десятки, а то и сотни вебмастером и менеджеров, которые проверяют с помощью А/Б тестов каждое изменение своего проекта, заказывают аудит в usability-лабораториях и ждут роста конверсий в пресловутые 2 раза. Что происходит на самом деле — давайте разберемся…На самом деле, А/Б тест — обычный статистический эксперимент и полностью подчиняется всем правилам статистики. По этим правилам понятия «изменение конверсии на 17%» существовать не может.

Для тех, кому интересно обоснование Может существовать: изменение конверсии на 17% с доверительным интервалом 10%(в этом случае — изменение — значимое).А может быть и так: изменение конверсии на 17% с доверительным интервалом в 20%(в этом случае — изменение — незначимое).

Какие переменные необходимо знать, чтобы изменения разошлись с доверительным интервалом?

1) Размер контрольных групп (вводные: 95% доверительный интервал, статистическая мощность 80%);  , где

, где

где δ — минимально обнаруживаемый эффект в %;

p — базовая конверсия

n — число участников в каждой группе.

Тогда для базовой конверсии в 2% и изменения на 17%(0,34%) необходимо:

n = (16×0,02*(1–0,0034))/0,0034² = 27731 участника в каждой группе, чтобы зафиксировать изменение значимым.

2) Доверительный интервал:

, где

, где

p — базовая конверсия

n — число участников в каждой группе.

z — 2 для 95% точности, 3 для точности в 99,8%

Пример доверительного интервала для конверсии в 2%, точности в 95% и размера выборки в 10000:

= 0,0028 (0,28%, а значит все значения, полученные в ходе эксперимента, но лежащие между 2,28 и 1,72 — не являются значимыми).

= 0,0028 (0,28%, а значит все значения, полученные в ходе эксперимента, но лежащие между 2,28 и 1,72 — не являются значимыми).

Из этого можно сделать предположение, что для большинства сайтов Рунета проведение А/Б тестов не может дать значительного результата, просто трафика у них мало.

Хотя сейчас большинство SaaS решений показывают результаты А/Б тестов на любой и даже статистически не значимой выборке, отсюда можно сделать и делается множество неверных выводов.

Перед нами была поставлена задача сверху — научиться проводить А/Б тесты и пользоваться этим постоянно.«Что может быть проще» — подумал я, делим весь трафик по юзер куке на четную/нечетную, вешаем что-нибудь в URL и Я.метрика или GA сами расскажут всю правду про тестирование. Это сейчас я понимаю — как ошибался.

Нам очень сильно повезло. Наш Системный Архитектор быстро ознакомившись с матчастью все понял и сделал несложный интерфейс по пересчету всех нужных параметров. Мы начали измерять (для справки — суточная посещаемость сайта редко падает ниже 30 000 уникальных пользователей):

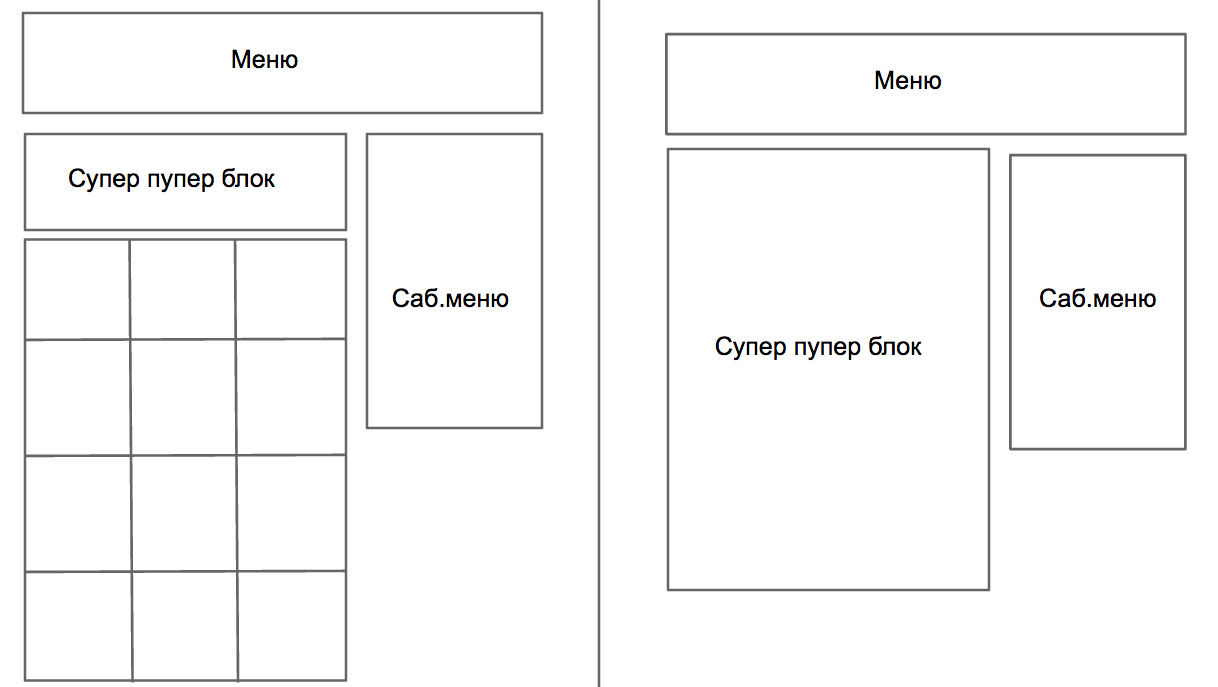

А/Б тест №1 (Тест на наличие блока рекомендаций для пользователя (очень хотелось начать, дать жизнь проекту, получать лиды)):

Я смотрю, как сказать, «по маячкам», Архитектор — все пишет.

Первый день +10% лидов на контрольной группе с блоком, я потираю руки (пахнет премией).

Второй +9% — ничего зажигаем

…

Прошла неделя, в среднем по маячкам — хороший + 7%, заканчиваю А/Б тест, включаю блок для всех пользователей. (Архитектор говорит — «интервал не разошелся». Я не придал этому значения).

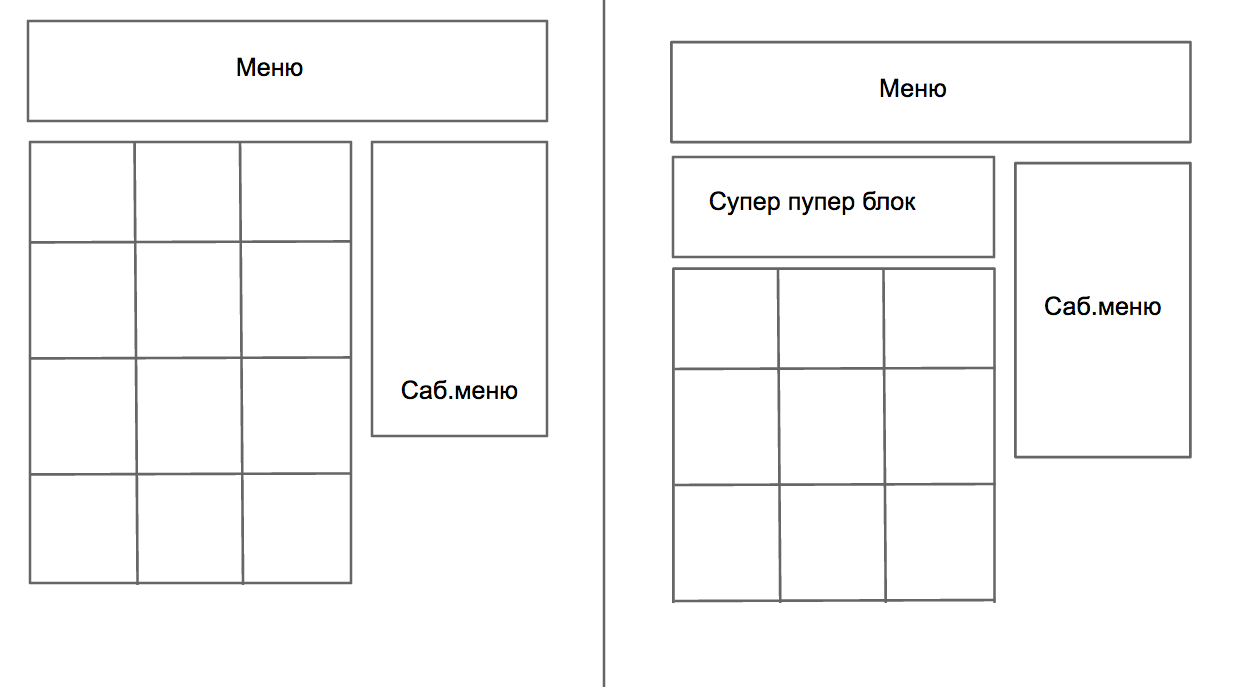

А/Б тест №2 (Тест размера блока рекомендайций)

Гоняли тест больше месяца — значимого результата — нет.

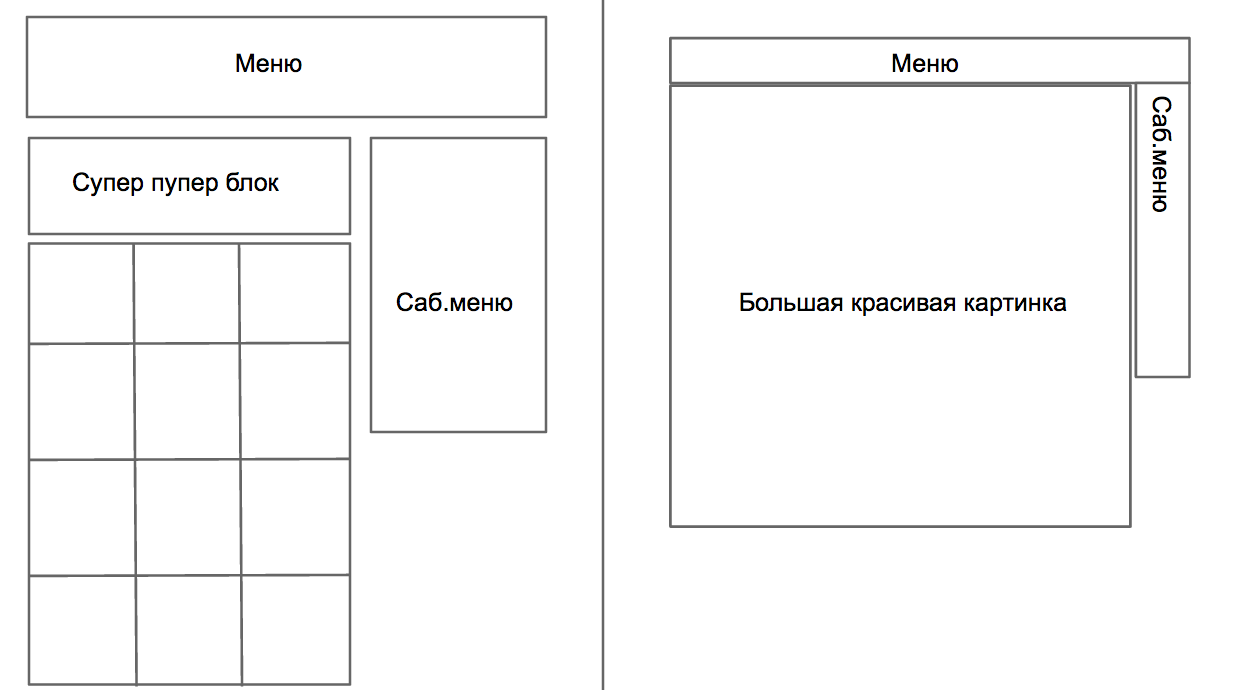

Докладываем руководству голосом — А/Б тесты проводить научись — все умеем считать. На что поступает новая задача:, а давайте сделаем сайт как Apple.com с одной большой картинкой и минималистичным меню.

А/Б тест №3 (Агрегатор vs Монобренд)

«Да так делать нельзя, мы столько трудились над динамическими рекомендациями —, а тут здравствуйте, как Apple.com» — эмоций было много, но делать нечего — кое-как сделали, запустили тест.

Первый день и тестовая страница привозит больше и больше — на 13%. У меня ужас, а как же моя экспертиза… начал ботать матчасть.

Второй день — показатели уравнялись, понял, что нужно ждать.

Прошло 10 дней, доверительный интервал наконец-то разошелся, старая страница оказалась действительно лучше, но не в разы, а чуть чуть. На общий уровень конверсии по холодильнику +12% с доверительным интервалом в 10%, т.е. всего в 2-х процентах можно быть точно уверенным или гонять тест дальше.

Прошу при проведении А/Б тестов не допускать моих ошибок, проверять статистическую значимость результатов, спрашивать, как были сделаны те или иные выводы, на основании чего.

P.Ы. А/Б тесты для проектов за второй тысячей Российской алексы — миф. Трафика не хватит.